5 Search-Trends:

5 Gründe, warum Suchmaschinen schlauer werden

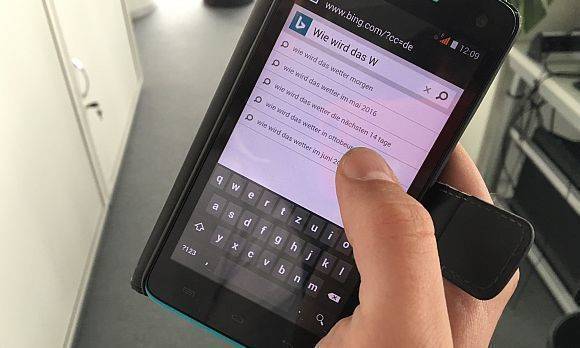

Die Zukunft der Suche heißt Mobile. Dabei befeuert das Smartphone fünf Search-Trends, denen eines gemeinsam ist: Die Suchmaschine wird schlauer und der Nutzer gleichzeitig immer bequemer.

Foto: W&V/S.Herrmann

Die Suchmaschine ist zu unserem besten Freund geworden. Wir schlagen kein Lexikon oder Wörterbuch mehr auf, sondern fragen Google oder Bing. Wir rufen auch nicht mehr an, um eine Information zu erfragen, sondern bitten eine Suchmaschine um Antworten. Es gibt unzählige Situationen, in denen für uns nur noch das Suchfeld im Netz in Frage kommt.

Die Konzerne hinter den Suchmaschinen arbeiten mit Hochdruck an ihren Algorithmen und einer künstlichen Intelligenz, um immer bessere Ergebnisse liefern zu können. Aber nicht nur das Suchvolumen verändert sich. Das gesamte Suchverhalten unterliegt einem Wandel, den Google, Microsoft und Co. mitgestalten wollen. Aber wie sieht die Suchmaschine der Zukunft aus? Um eine Sache kommt man hierbei nicht herum: Mobile. Weil wir vieles nur noch mit dem Smartphone erledigen, sind mobile Anwendungen jetzt schon das Nonplusultra. Das gilt selbstverständlich auch für die Suche.

Durch die zunehmende Suche auf dem Smartphone ergeben sich weitere Trends. Fünf wichtige Suchmaschinen-Trends unter dem großen Aspekt Mobile sind: Sprachsuche, Personalisierung, Bots beziehungsweise Assistenten, Bilderkennung sowie native Inhalte.

Sprachsuche – der Bequemlichkeitsfaktor

Bequem am Desktop-PC die Suchanfrage eintippen und auf ein gutes Ergebnis hoffen, das ist immer seltener der Fall. Vieles erledigen wir inzwischen mit unserem Smartphone. Wegen der fehlenden großen Tastatur und dem Stress-Faktor – unterwegs muss alles etwas schneller gehen – ist es unvorteilhaft, zu tippen.

Stattdessen nutzen wir die Sprachfunktion und tun fast so, als würden wir mit einem Freund reden. Wichtiger wird in diesem Zusammenhang deshalb auch die Semantik: Die Suchanfrage lautet häufig nicht mehr "Wetter Frankfurt", sondern zum Beispiel "Wie wird das Wetter in Frankfurt". Google und Co. verstehen uns also im wahrsten Sinne des Wortes immer besser. Das gilt sowohl für die Texteingabe als auch für die Sprachsuche, die bei der mobilen Nutzung langfristig dominieren wird. Ausgereift ist die Technik allerdings noch lange nicht.

Assistenten – mein Freund und Helfer

Noch einen Schritt weiter gehen virtuelle Assistenten, sogenannte Bots, wie Apples Siri, Google Now oder Cortana von Microsoft. Sie sind speziell darauf ausgelegt, uns auf dem Smartphone als Freund und Helfer zur Seite zu stehen. Die Bots wollen die klassische Suchmaschine, bei der wir einen Text in eine Suchmaske eingeben, ersetzen und verbessern.

Auch kontextbezogene Anfragen sind mit den Sprachassistenten schon möglich. Beispielsweise zeigen sie uns die nächstgelegene Tankstelle an. Oder sie verraten uns, wie wir von unserem Standpunkt am schnellsten zu einem anderen gewünschten Ort gelangen. Selbst freihändiges Surfen im Internet ist dank der Assistenten möglich – zumindest teilweise. Noch sind die Systeme nicht ausgereift, einige Funktionen nur auf Englisch verfügbar. Aber Siri, Cortana und Now haben definitiv das Potential, die mobile Suchmaschine Nummer eins zu werden.

Personalisierung – ich bin kein Unbekannter

Search Engines wollen uns näher kennenlernen, sprich: Sie brauchen mehr Daten von und über uns mit dem Ziel, uns personalisierte Suchergebnisse liefern zu können. Schon heute ist es normal, dass beispielsweise vorherige Klicks und Suchanfragen die kommenden Anfragen und Ergebnisse beeinflussen.

Insbesondere auf dem Smartphone ist die Personalisierung von Suchergebnissen ein wichtiges Thema. Doch es geht noch über den bloßen Suchverlauf hinaus. Smartphones liefern deutlich mehr Daten: Apps verraten, welche Spiele wir spielen, welche Nachrichten wir lesen, wo wir uns befinden und vieles mehr. Das wollen Google, Microsoft und Co. noch stärker für die eigenen Angebote nutzen, um sie besser auf den Nutzer zuzuschneiden.

Bilderkennung – das visuelle Gedächtnis

Visuelle Inhalte werden überall wichtiger, auch für Suchmaschinen. Konkret geht es hier um eine bessere Bilderkennung. Dabei spielt weniger ein Algorithmus, sondern vielmehr die künstliche Intelligenz eine Rolle.

Googles künstliche Intelligenz erkennt etwa automatisch den Aufnahmeort von Bildern. Je mehr Bilder im virtuellen Gedächtnis abgespeichert sind, desto besser kann Google Orte anhand von Bildern erkennen. Genauso gut ist es möglich, dass eine Suchmaschine ein Bild mit einem bestimmten Tier erkennt, weil es viele andere Bilder mit dem gleichen Tier bereits "gelernt" und abgespeichert hat.

Native Inhalte – ein Klick weniger

Eigentlich sind Suchmaschinen Tools, die uns zu einer Anfrage viele verschiedene Links bieten. Das ist und bleibt auch in Zukunft so. Allerdings wird das um einen Service ergänzt, der es den Nutzern noch bequemer machen soll.

Es handelt sich um eine Art Native Content, also Suchergebnisse, die nicht nur aus einem Link bestehen, sondern schon aus dem eigentlich Ergebnis. Google nennt das "Snippets" und zeigt beispielsweise Definitionen aus Wikipedia an. Auch bei der Suche nach dem Wetter oder der aktuellen Fußball-Bundesliga-Tabelle müssen Nutzer keinem Link mehr folgen, sondern können das Ergebnis direkt in Google ansehen.